NeRFが使われた制作の裏側

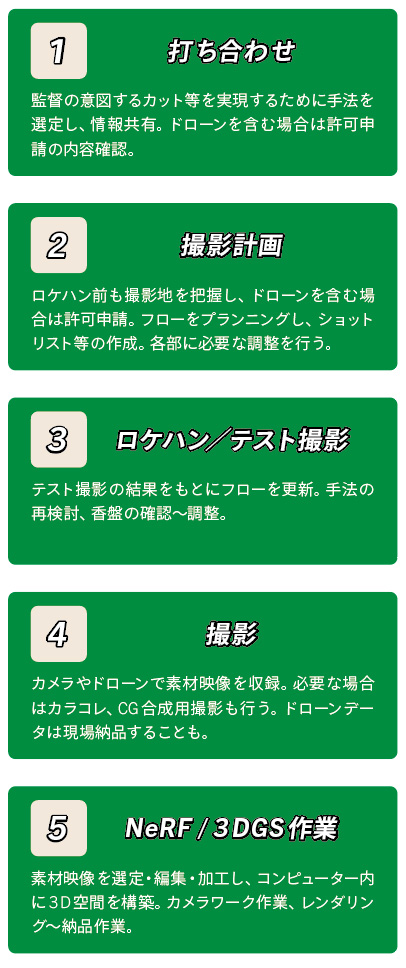

制作のワークフロー(一例)

現実的な撮影リスクをNeRFで解決した例

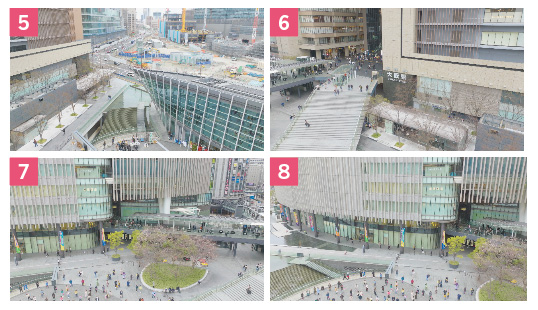

● グランフロント大阪ブランドムービー

まちびらき10周年に合わせた映像を空撮メインで制作。大阪・梅田駅前で800名ほどのエキストラ上の空撮など、リスクが高いカットにNeRFを使った。

バーチャルロケハンでシミュレーション映像を作成

● 必ず規制をクリアしてから本番に臨む

空撮の許可申請をするには撮影プランが不可欠。今回はGoogle Earth Studioを使い、事前にバーチャルロケハンをしてシミュレーション映像も作成。監督が望む画角でのカメラワークがどのくらいの尺で可能になるか検証した。

撮影プランに合わせて、飛行範囲や高度も検証。年間の許可範囲内に収まっているかを確認、警備員や補助者の配置や人数も予測し、範囲の地権者の許可取りを進めるなど、細かな段取りのもと本番に臨んだ。

ドローンでは実現できなかったNeRFのシーン

● FPVドローンや安定型ドローンでは撮れない表現

「子ども、複数人、大人数の連続する3カットで縦回転するカメラワーク」という要望に応えるために、大人数のカットでNeRFを使用。子どもと複数人のカットでは、照明のセンチュリースタンドを被写体の両脇に置き、回転できる軸を作って先に取り付けたカメラで撮影したが、大人数の脇にスタンドを置くことができず、FPVドローンは危険だったためNeRFで解決することにした。

NeRF素材撮影時のポイントと注意点

撮影に使ったのはMavic 3。広場に集まった大人数を中心にレンズを向けながら、旋回しつつ上昇していき、2周目以降はオーバーラップするようにアングルを変えて撮影した。撮影中に動きが発生しないよう、エキストラの持つ旗も硬めにしてもらったそうだ。

カメラワークの制限や撮影のリスクを回避するために使用したNeRFのシーン

実際にNeRFを使った作品を紹介します。グランフロント大阪という巨大施設を空撮メインで制作したいと相談いただきまして、撮影のリスクがあるシーンにおいて、2022年6月からテストしていたNeRFで解決したものです。

準備段階のお話しもすると、大阪・梅田駅北側の再開発エリアにグランフロント大阪の施設が4棟ありまして、うめきた広場という場所の撮影でNeRFを使うことになりました。南館・タワーAは地上高179.5mあるので、高さ150m以上をドローン飛行する場合の許可申請も別途必要になりました。これだけ大規模でなおかつ人も多い駅前でドローンを飛ばす行為に対して、弊社としてもいつも以上に身の引き締まる思いで許可申請をしていましたね。

おそらく弊社しかやっていないのはGoogle Earth Studioでのバーチャルロケハンとシミュレーション映像制作ですね。元CG屋さんだから得意な領域ですが、このソフトはクセがすごく強くて、慣れていないと扱いづらいんです。でも、ドローンのプラン立てと相性がよく、完成図をイメージしやすいので、わりと好評をいただいています。

本番では安定型ドローン、FPVドローン、マイクロドローン、地上カメラ&ジンバルなども用いて撮影しました。最初にNeRFを検討したのは、監督から「ビルの上から降下してバスの中に座る人が持つスマホ画面に突っ込みたい」という要望があったからです。ロケハンで簡易的にNeRFを作ってみたんですけど、結果的にこのシーンではNeRF不使用に決定しました。というのも、シネウープタイプの自作FPVドローンの上にハンドルを取り付けて、バスの中まで飛行し、待ち構えていたスタッフがハンドルを掴んでスマホ画面に突っ込めば実現できると考えたからです。もちろんNeRFで作ればもっと自由度のあるカメラワークにできたんですが、空間が広すぎるのできれいに再現できるか確証が持てませんでしたし、木の細い枝などはNeRFでは再現できないだろうという予測もありました。

もうひとつ検討して最終的にNeRFを本番使用したのが、子ども〜複数人〜大人数を縦回転するカメラワークで撮ったシーンです。この大人数の部分が問題で、そんなに大きな縦回転用のリグは組めないですし、FPVドローンでそのように飛ぶのも人にぶつかってしまう恐れがある、と。あるいは安定型ドローンで撮影した動画を後処理で早回しや天地逆転しても不安定になってしまう。そこで、大人数の縦回転だけNeRFを使うことになりました。

NeRF素材撮影時の注意点は、撮影中に動く物は最終結果がボケ、モヤ、ゴミのような結果になる、ということですね。人や物の動き、風による木々の揺れや水面の変化、光の変化などがある場合は、いろいろと辻褄が合わなくなってしまいます。今回のNeRF素材撮影は本番1回きりというのもポイントでした。800人ほどのエキストラさんは、ドローンで素材撮影しているときに静止してもらわないといけなかったので、拡声器でアナウンスしながら行いましたが、ドキドキしながら撮影したことを覚えています。

学習させて得られたNeRF結果

素材を学習させて得られたNeRF結果を細かく見ると、エキストラの静止も完璧にはできなかったため人物の顔などがボケているが、一瞬のカットとワークの中ではあまり悪目立ちしない程度のものに仕上げた。一方で、地面のタイルの目地などはくっきりとディテールを持って再現されている。

Depthのデータも制作しておく

NeRF結果からはDepthのデータのみを取り出すことも可能。ポストプロダクションで使う場合を想定して制作したそうで、これによって後工程でブラーを強めるなどの処理がしやすくなる。

実験として同じ素材で3DGS化してみると…

本番ではNeRFを使ったが、後日同じ素材でテスト的に3DGS化したものがこちら。一般的に3DGSの長所として高品質でフォトリアル、よりディテールがあるように見えるが、タイルの目地はボケてしまっている。

CG学会の国際会議でも紹介されたNeRFによる実現不可能なカメラワーク

立命館大学 大阪いばらきキャンパスのコンセプトムービー『来たぜ、新次元大学。』のお仕事でもNeRFを使用しました。当初は空撮のみ参加予定でしたが、ビルダイブのNeRF映像〜360度カメラでのモデルさんの撮影も担当しています。ビルダイブの画はFPVドローンで撮ることがありますが、この現場ではビルとビルの間隔が狭すぎたため危機回避ができませんでした。そこで安定型ドローンで空撮してNeRFに変換し、Unreal Engine 5でカメラワークをつけてレンダリングした映像を納品することになったんです。

この作品はSIGGRAPH(シーグラフ)という50年続くCG学会の国際会議・展示会でも紹介されました。Volingaというバーチャルプロダクションなどのサービスを提供するアメリカの会社が、講演で事例として扱ってくれたんです。そのときにフェルナンド・リーバスさんというファウンダーの方からご連絡があって、「NeRFを用いて実現不可能なカメラワークを生み出し、実際の映像からNeRF生成映像へのシームレスな移行に、講演の参加者は驚いていました」とお褒めの言葉もいただけました。

NeRFで実績が増えていく一方で、3DGSの進化が著しく、導入する機会をうかがっていたんですが、最近本格的に導入することができました。それが小石川植物園の空撮と3DGS制作のお仕事です。この植物園は植物学の研究・教育を目的とする東京大学の附属施設で、488,800坪という広大な敷地を有しています。

依頼いただいたのが植物学を専攻されている東京大学大学院理学系研究科の塚谷裕一教授で、「園内の景色や植物などいろいろと撮影し、虫の目線、鳥の目線など、普段見れない視点で空撮してほしい」というご要望をいただきました。そこで、植物の枝の間を空撮するFPVドローンでの映像と共に、3DGS素材の撮影も行うことにしたんです。

今回の撮影期間内に数年〜十数年に一回、しかもほんの2〜3日しか咲かないとも言われているショクダイオオコンニャクの開花に遭遇しました。せっかくの機会なので3DGSを用いて保存させていただいたんですが、絶滅危惧種にも選定されているそうなので貴重な機会となりました。

3DGSが使われた制作の裏側

東京大学の付属施設・小石川植物園の空撮と3DGS制作の最新事例

● 園内の景色や植物を普段見れない視点で撮影

植物学を専攻している塚谷教授の案内のもと、広大な敷地の園内で景色や植物を撮影していった。安定型ドローンで園全体を見渡せる俯瞰ショットを、FPVドローンで木々を通り抜けていく臨場感のあるショットなどを撮影。また、貴重な樹木の付近では保存の観点からも有益な3DGS素材の撮影を安定型ドローンとジンバルに乗せたカメラ(今回使用したのはテスト撮影で3DGSとの相性が良かったiPhone)で行い、誰でもWEBブラウザ上で閲覧できるようなデータとして作成した。

歴史的に価値のある小石川植物園のオオイチョウ

●貴重な「精子発見のイチョウ」の3DGS制作

植物園のほぼ中央にあるオオイチョウは、種子植物にも精子が存在することを発見した際の研究材料。日本の初期の生物学者による世界的な発見で、生物学史上の偉業とされているこのオオイチョウを囲む付近の風景を3DGS保存するために、北川さんはテストを行なっているそうだ(23年12月現在)。

数年〜十数年に一度しか開花しないショクダイオオコンニャクを3DGS保存

● 開花前の温室内の様子

今回の撮影期間中にたまたま遭遇したのがショクダイオオコンニャクの開花。このように数年〜十数年に一度しかないという貴重な瞬間を保存できる意味でも、3DGSの可能性はありそうだ。データの中には右画像の文字のようにポリゴンを置くこともできるため、CGとの親和性も高い。

https://my.spline.design/untitledcopy-2bd0a864d7136f25350b7e65a5cbea50/

現時点でのNeRF / 3DGS関連各種アプリ・サービス

マイクロドーンよりも好きに動けてもっと自由な視点が得られる

NeRFや3DGSの技術・サービスは日進月歩で、進化のスピードに食らいついていくのに必死です。前述のVolinga・フェルナンドは「2024年後半には、HDRガウシアンを提供し、色補正により適した、より広色域の色空間をサポートするよう取り組んでいます」と連絡をくれました。3DGSは現在未対応のHDRでの作成がもうすぐ可能になるそうです。

NeRFの最初の論文が出たのが2020年でしたが、当時は「未来が来たぞ!」と興奮だけして何もせず終わっていました。転機は2022年3月ごろにNVIDIA Developerの動画を見たこと。NVIDIAのInstant NeRFという技術が紹介されているんですが、複数の写真を読み込ませるだけで3D空間の自由視点が得られていたんです。「これならマイクロドーンよりも好き勝手動けるし、もっと自由な視点が得られる」と思って、自分でもやってみたくなりました。初期の頃はYouTubeで海外の解説動画を漁って見たりして試行錯誤しましたが、いまは上の表にあるようなNeRF / 3DGS関連のアプリやサービスが少しずつ充実してきています。

URL:https://www.nvidia.com/en-us/research/

URL:https://docs.nerf.studio/

URL:https://lumalabs.ai/

URL:https://volinga.ai/

URL:https://poly.cam/

AIが絡む映像制作は今後どうなる?

生成AIを用いて静止画〜動画を試行錯誤中

NeRFや3DGSだけでなく、画像・動画生成AIにもハマっているという北川さん。2020年の夏ごろからDALL-E2、Stable Diffusion、Midjourney、Kaiber、Runway、Wonder Studio…など、手当たりしだいに試していたそう。上画像は北川さんがStable DiffusionやMidjourneyで生成した静止画を、Runwayで動画にし、簡易的につないだリールのキャプチャー。

3DCG屋さんとドローン屋さんで培った技術で自由視点映像のクオリティを向上していく

生成AIの進化を見ていると、「ヤバいな、これ…」と感じることが最近多くなっています。仕事柄、個人的に興味が向いているのは空間系のNeRFや3DGSといった技術ですけど、たとえばNeRFや3DGSで作った動画を生成AI でスタイルチェンジしたり、AIで高解像度化したり…と、組み合わせることもできると思うんです。

今後の見通しとして、動く3DGSを誰もが撮って、保存・加工できるような世界、つまり空間、物体、体験の“民主化”が進むと思います。0からの制作、実写から変換、キットバッシュ、指示…なんかは自動化していくでしょう。20年ぐらいCGをやってきましたけど、AIの力を借りたらそれと同じようなことをAIと共に作成できるんだろうな、と。

そんななか、映像制作にも何かしらAIが絡んでくることになりますが、実写撮影にしかない価値は今後も薄れませんし、プロの人が持つ経験値や作家性、プランニングの力などの重要性は変わらないと思います。あと、バーチャルプロダクションの分野は今後も加速していくでしょう。

一方で、ウォーターフォール型のフローのなかで下流の工程を担う人の仕事はAIに駆逐されるのか、より選んでもらえる仕事になるのかの分かれ道に来ている気がします。私もドローンだけをずっとやっているようだとマズいと感じていて、生成AIで空撮できるようになるかもしれませんし、実景を撮るだけの仕事は今後なくなるだろうな、と予測しています。AIによって好きな場所で好きなアングルの映像が撮れたら、誰もドローンを使わないですから。

さらにAGI(人工汎用知能)が絡む世界が来たらまたどうなるのか分かりません…。人を感動させるもの、という点では今後も変わらないものもあるだろうし、めちゃくちゃ変わるものもありそうでドキドキしていますね(笑)。

ただ、そもそも私は、自由視点映像への新たな挑戦としてドローン屋さんを立ち上げました。自作ドローンでの空撮はもちろんですが、最近はNeRFや3DGSに魅了されてその可能性を追求するために日々経験値を貯めているところです。CGの経験、ドローンでの経験、NeRFや3DGSの経験、さらに勉強中の生成AIまで、すべてまるっと制作できるのが、弊社の強みになってくると思います。

これからも生成AIの助けを借りながら、3DCG屋さんとドローン屋さんで培った技術によって、自由視点映像のクオリティ向上に努めていきたいですね。